8eg快充网络

引言

几天前OpenAI进一步推出了其文生视频的模型Sora,再次引起了轰动。8eg快充网络

Sora不仅支持最大支持60秒高保真视频生成,而且支持短视频前后扩展,即保持视频连续,并扩展时长。8eg快充网络

而就在不久前,RunWay、PiKa 还有Midjourney, 它们发布的文生视频模型仅支持2~3秒,即使这样他们的成功已经使我们感到震惊,因为就在我毕业的时候那是还是GAN模型大行其道。8eg快充网络

这次可以说,Sora硬生生的将RunWay、PiKa等采用Diffusion Model实现的文生视频模型按在地上进行摩擦。8eg快充网络

当前,视频广告、电商营销要求的视频连续时间平均在30秒左右,Sora支持60秒的高保真视频的生成,“嗅觉灵敏”的人已经意识到Sora从底层改变内容生产方式,Sora待发布的阶段就是筑底阶段,多模态发展迎来新阶段,商用空间会大幅打开。8eg快充网络

我们先来看几个Sora生成的视频,并分析一下。8eg快充网络

00:20

就拿这个追车场景来说,完全可以通过文生视频的方式进行生成一段汽车追逐戏,这样避免了高价请一些特技人员,或者为一段景而修一条路的传统拍摄手法。8eg快充网络

其实就在去年我在听一些讲座的时候,有些在“开发LLM大模型落地应用前线”的人依然在发表这样一些观点,“认同AI的发展前景,但当前ChatGPT噱头大于前景”,甚至有人预测,”ChatGPT会和当年的比特币一样”。8eg快充网络

他们的观点一般为,由于ChatGPT是基于预测下一个词的预训练生成模型,无法解决或不可避免的存在幻觉问题,这使得在医疗咨询,产品toC问答,自动驾驶等一系列高价值投资领域应用存在风险,其只能作为一个助手的角色,即辅助工具。8eg快充网络

他们的观点,其实是一部分是来自于基于国内类GPT3.5产品,在创建落地应用时高期望、低回报的失望所带来的。8eg快充网络

不可否认,到目前为止任然没有基于ChatGPT的爆款现象级产品的诞生,但回归技术角度,ChatGPT的诞生是否是IPhone时刻,如果是那确实会对世界带来一些改变。8eg快充网络

我认为是的,ChatGPT让世界再次重视起神经网络,虽然它是黑盒不可解释,但你不得不用,因为它是真的有效。8eg快充网络

ChatGPT创新和原理

网上有很多关于ChatGPT原理的文章,一些把ChatGPT比作是文字接龙游戏,描述其就是个预测下一个字出现概率的函数,这种理解仅仅讲述了其实现方式或过程,但忽视了其最重要的一些底层创新。8eg快充网络

Transformer在2017年就被Google提出,作为使用Transformer自然语言处理模型来说,BERT在近几年也有很亮眼的表现,然而并没ChatGPT的轰动效应。8eg快充网络

可以说ChatGPT中的一些概念和原理并不新鲜,但自从ChatGPT发布以来网络超过千名产业界和学术界的大佬呼吁全球所有实验室暂停至少为6个月研发比GPT4更强的AI模型。8eg快充网络

可以说ChatGPT最重要的创造就是为我们跑通了一条新的AI发展路线,我们称之为LLM范式,即以大数据和大参数量的通用大模型为基础的路线,即利用计算资源来实现通用计算方法的胜利。8eg快充网络

我们就以Sora举例,当RunWay、PiKa 还在为文生视频中的连续性、一致性问题通过微调或改造模型来缓解这些问题时,通过Sora直接没有这些问题,当模型变大,训练数据变大,这些问题自然消失了,甚至还产生了很多超乎想象的新的能力。8eg快充网络

8eg快充网络 8eg快充网络

可以说这又是一次的是大模型参数+大数据量训练的胜利,为此OpenAI在2020年还提出了大模型的Scaling Law的概念,它被看作是 OpenAI 最核心的技术,Sora 的出现也被认为是 scaling law 的又一次成功。8eg快充网络

而非常搞笑的是网络上分析未来文生视频的方向是解决一致性和连续性问题的文章还在,甚至有些就发布在不久前。8eg快充网络

Transformer的并行计算的特性使得处理大量数据成为可能,这也许是当前Transformer在不同领域中开花的重要的原因之一,当新的模型架构其性能和网络结构更优于Transformer时,那它将可能替换掉Transformer。8eg快充网络

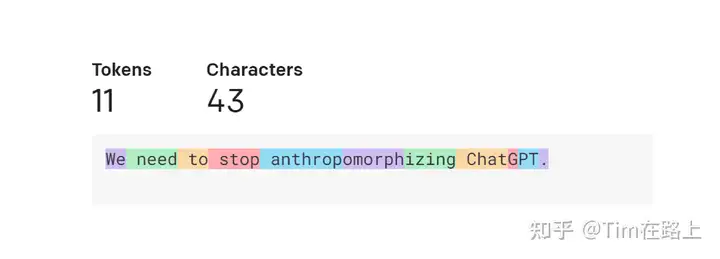

另一个LLM范式成功的重要原因就是tokens的使用,tokens作为大模型的输入,它优雅地统一了文本代码、数学和各种自然语言的不同模式。8eg快充网络

这看起来是一个相当简单的概念,即将输入划分为tokens,最终产生一个token作为输出,而不是直接以单词作为输入。8eg快充网络

但这部分看似数据工程的工作也是非常重要的,为此OpenAI还专门发布了一个Python tiktoken包。8eg快充网络

我们解释一下token是什么,token就是一段文本,例如下面的句子它被划分为11个token。8eg快充网络

8eg快充网络 8eg快充网络

当前OpenAI给出的一个token通常对应于常见英语文本的约 4 个字符,这相当于大约 3/4 个单词。8eg快充网络

这是为什么呢?8eg快充网络

如果我们尝试最简单的实现,其中每个字母都是一个token,那么将文本解析为将token很容易,token总数也很小,但是我们无法编码与 OpenAI 方法中一样多的信息,而且模型对它们可以接收的最大token数量有限制,我们希望在每个 token 中包含尽可能多的信息。8eg快充网络

如果我们以一个单词作为一个token,那么上面例子中的句子我们只需要 7 个 token 就可以表示同一个句子,这似乎更高效,按字拆分也很容易实现。8eg快充网络

然而,语言模型需要有一个完整的可能遇到的token列表库,而这对于整个英文单词来说是不可行的——一方面因为字典中有太多单词会使得词库很大,另一方面因为很难跟上领域的步伐——特定术语和发明的任何新词。8eg快充网络

因此,OpenAI 设计开发了一个介于这两个极端之间的解决方案。8eg快充网络

除此以外,我们不应该忽视的一点是,ChatGPT就是一个深度神经网络,它和其他的神经网络一样,本质都是让网络学会从输入数据中提取有用的特征,然后根据这些特征做预测。8eg快充网络

这个训练过程涉及到前向的网络训练和计算损失函数,和反向通过优化器来调节网络参数的梯度,并根据这些梯度来更新网络参数,使得损失函数值逐渐减小。8eg快充网络

在GPT中每一个token可以用一个Embedding来表示,Embedding是一个多维的数据矩阵。如果三维空间中,我们可以想象其为一个空间坐标系中的一条线,不过在真实的模型场景中,它一般是在非常高的维度空间中。8eg快充网络

在模型训练前可以随机初始化,即随机的为每一个token画了一个线段表示,随着模型的训练不断的更新Embedding,那么token所对应的空间线段,也在不断的平移转换,当训练的精度较高时,也就说明token所对应的空间线段,移动到了其在空间中本该所在的正确位置。8eg快充网络

当我们进行推理预测时,输入一个token将其转换为对应的空间线段,寻找离这个token线段最近的token作为下一个单词的输出,这时ChatGPT就回答出来了下一个单词。8eg快充网络

然而让我们感到震惊的不是其正确的回答,而是其具有了一定的逻辑和推理能力,这是我们现在无法控制和解释的。8eg快充网络

我们先来看一道题目:8eg快充网络

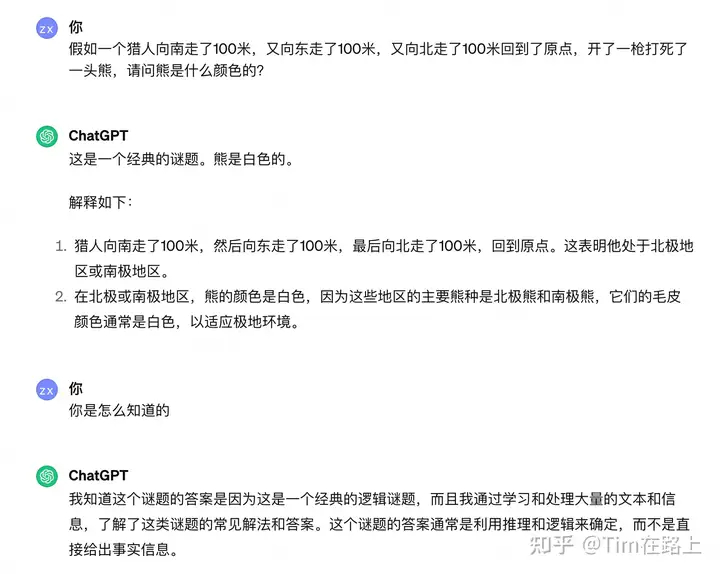

假如一个猎人向南走了100米,又向东走了100米,又向北走了100米回到了原点,开了一枪打死了一头熊,请问熊是什么颜色的?8eg快充网络

你可以先思考一下这个问题,尝试是否可以回答。8eg快充网络

8eg快充网络 8eg快充网络

如果你回答的是白色,恭喜你和GPT4回答的结果一样,这是一个经典的逻辑谜题,如果按照人类的思维,需要先计算通过“向南走了100米,又向东走了100米,又向北走了100米回到了原点”这句话判断出位置是在北极,然后通过北极和熊关联想象到为北极熊,最后推断为白色。8eg快充网络

而ChatGPT是当我们将问题输入模型中后,一个token一个token的文字接龙,前面所串联的所有词会决定最后一个词的结果,最后离颜色这个token最近位置的token就是白色。8eg快充网络

这可以想象为在更高维的空间中逻辑推断,也许就是显而易见的。8eg快充网络

你可能会质疑是否有人已经问过ChatGPT这个问题,我们要知道ChatGPT是预训练模型,其token在向量空间中的位置,在模型训练结束就已经固定。ChatGPT不可能再根据每个人的问题再去调整模型中的参数。8eg快充网络

ChatGPT训练数据截止到2022年1月,这也就是为什么他不了解2022年1月以后得事情。但你可能会说为什么我用的AI机器人知道2022年以后得事情,那是因为有些市面上AI机器人用类似LangChain框架封装,它会在问答前先从网上进行搜索,然后和问题一起打包发给ChatGPT。8eg快充网络

我们可以想象在ChatGPT构建完token词库后,每次训练就是调整每个token在向量高维空间中的位置,训练结束,整个人类的文本语言体系就压缩到了这个空间中。我们的问题就是ChatGPT现场在空间中组织串联的结果。8eg快充网络

而当训练的数据量足够的,算力足够多,参数量足够多,训练到一定程度,每个token找到了其在高维世界中的真正位置,那么其预测的准确性也就越来越好。8eg快充网络

结论

这篇文章是想到哪里写到哪儿,本来还想写Sora的架构中的关键点的,就到下一个篇幅吧。8eg快充网络

OpenAI选择从解决语言模型入手,感觉其方向对的。人类的语言发展了几千年,其中千变万化,是非常复杂的,需要的资源是最多的,但又是一切的基础。8eg快充网络

如果把语言问题解决了,那么应用到其他问题上应该会更容易,例如Sora文生视频中,就利用 GPT4 将用户输入的简短提示词,扩充为复杂细节文本。8eg快充网络

所以说不论文生图、图生文,LLM 大语言模型仍然是核心。8eg快充网络

- Scaling Law:模型规模的增大是核心要义。小模型中存在的一些问题,例如文生视频场景中的一致性、连续性等问题,当模型变大这些问题就不存在了。不要通过非通用的方法来解决现在面临的一些可能因为算力,呈现效果的问题,随着时间的拉长,把模型和数据做大,通过通用的手段才是王道。

- Data Engine: 数据工程很重要 , 例如ChatGPT的输入,Sora的视频数据如何输入,是否截断等。

- 神经网络基本原理:由于参数规模较大,数据量较大,问题的模型依然采用的是预训练模型,通过推理推测的方式,这种方式并非完全贴合人类神经网络的原理。如果未来,可以实现真正的实时训练预测,那效果绝对更上一层楼。

|